- Hochschule Trier

- Campus wählen

- Quicklinks

-

- English

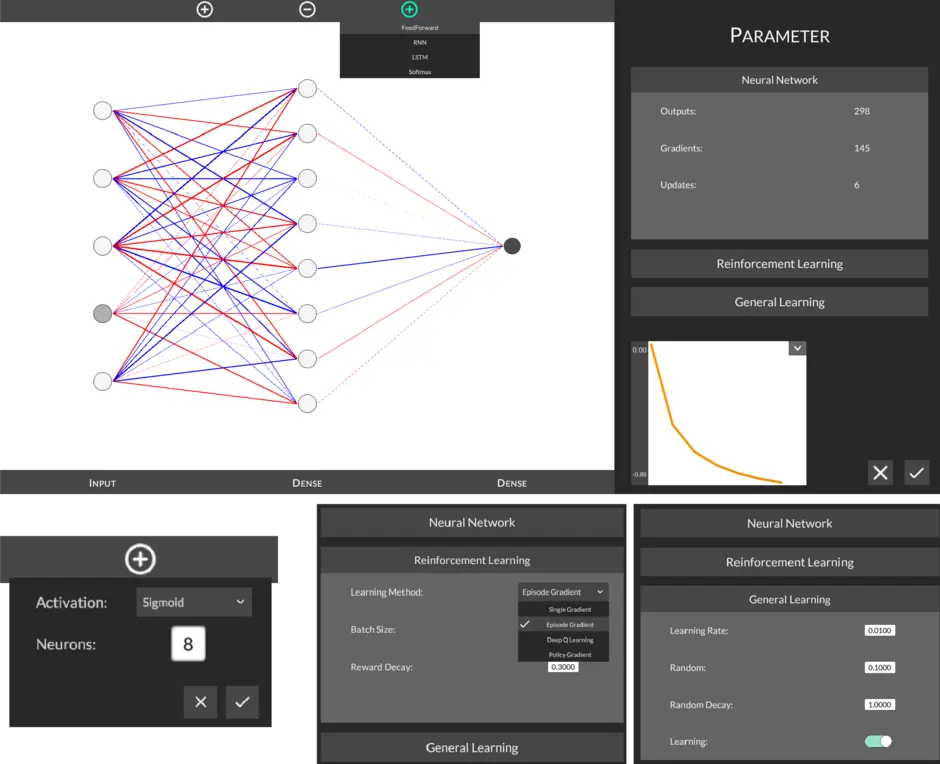

Um einen möglichst grundlegenden Einblick in die Mechanismen im RI geben zu können, hat Herr Wild die notwendigen Funktionalitäten zu neuronalen Netzten, wie dem Backpropagation-Algorithmus das stochastische Gradienten-Verfahren, und Verfahren des RI, wie Deep Q-Learning nachimplementiert. Mit Hilfe der Unity Entwicklungsplattform wurde dies in eine graphische Umgebung integriert. So lässt sich das RI basiert Trainieren der (Computerspiele) Pong, Tic-Tac-Toe sowie Snake in unterschiedlichen Netz- und Trainingskonfigurationen beobachten und analysieren.

Künstliche neuronale Netzwerke können eingesetzt werden, um einen Agenten im „Spielen“ zu trainieren. Dabei wird ein Zustand der Umgebung dem Netzwerk als Input übergeben. Beispielsweise repräsentiert ein 9-stelliger Vektor ein Tic-Tac-Toe Spielfeld. Für jedes der 9 Felder steht entweder „1“ für „Spieler 1 besetzt das Feld“, „-1“ für „Spieler 2 besetzt das Feld“ oder „0“ für „freies Feld. Ausgehend von dieser Eingabe errechnet das neuronale Netz eine Ausgabe. Die Ausgabe bestimmt die nächste Aktion des Agenten. Dabei gibt es verschiedene Wege einen Ausgabevektor zu interpretieren. In Deep Q-Learning beispielsweise wird immer die Aktion mit dem höchsten Ausgabewert gewählt.

Rl ist ein Methodenkollektiv, mit dem künstliche neuronale Netze trainiert werden können. Beispielsweise konnten Programme professionelle Spieler in dem Echtzeitstrategiespiel Starcraft 2 besiegen, in dem sich die künstliche Intelligenz zu jedem Zeitpunkt zwischen Möglichkeiten entscheiden muss. Die Methoden basieren auf dem Grundprinzip gute Aktionen auf- und schlechte abzuwerten. Dies auf neuronale Netzwerke übertragen, bedeutet, die Parameter in eine Richtung zu verändern, sodass eine Aktion in einem bestimmten Zustand öfter gewählt wird. Ein bedeutender Vorteil gegenüber anderen Lernverfahren, wie Supervised Learning, ist die Unabhängigkeit von gelabelten Daten mit manuell vorgegebenen Ausgaben. Also Datensätze, bei denen die korrekte Ausgabe bereits vorgegeben ist. Stattdessen werden die Daten von dem Agenten erst während des Spiels erfahren und verarbeitet. Eine Ausgabe wird von der Rl Methode errechnet und entsprechend dem Backpropagation-Algorithmus für die Parameter des Netzwerkes optimiert. Durch wiederholte Anwendungen entsteht ein Lernprozess. Allerdings bedeutet Rl, dass Lernprozesse langwierig sein können. Die von OpenAI bereit gestellte künstliche Intelligenz OpenAIFive trainierte 10 Monate lang, bevor sie sich in der Öffentlichkeit gegen professionelle Spieler des Strategiespieles Dota2 durchsetzen konnte.

Sie verlassen die offizielle Website der Hochschule Trier