- Hochschule Trier

- Campus wählen

- Quicklinks

-

- English

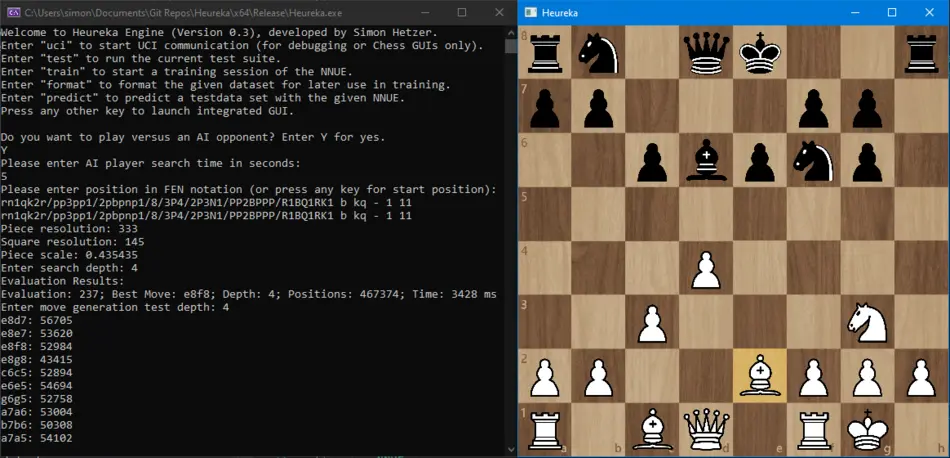

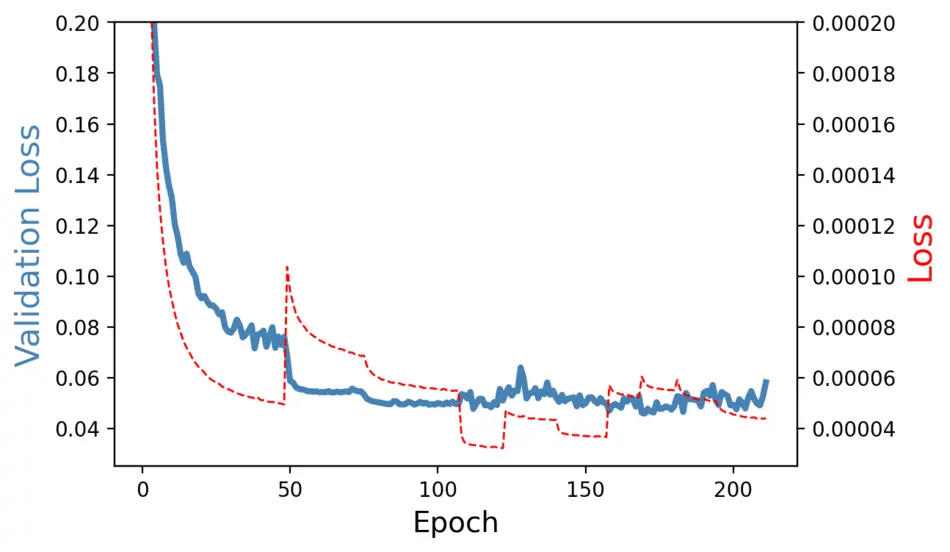

Efficiently Updatable Neural Networks (NNUE) haben in den letzten Jahren die Welt der Schachcomputer revolutioniert. Sie bieten die Möglichkeit, eine von einem Künstlichen Neuronalen Netz berechnete Stellungsbewertung effizient mit der Alpha-Beta-Suche zu kombinieren. In der Abschlussarbeit wurde die NNUE-Architektur mit der C++ Bibliothek mlpack rekonstruiert, um sie in das zuvor entwickelte Schachprogramm Heureka Engine einzubinden. Dazu wurden neue Netzwerkschichten entworfen und implementiert. Zur Überwachung und Auswertung des Trainings wurde eine automatisierte Trainingsroutine umgesetzt. Um das Netzwerk performant während der Suche nutzen zu können, wurde eine interne Repräsentation sowie die effiziente Berechnung des Forward Pass zur Engine hinzugefügt. In der Ausarbeitung werden die vorerst gescheiterten Trainingsexperimente dargestellt und in Bezug auf die Einstellung der Hyperparameter und Optimierer analysiert. Außerdem wird die Performanz der Anbindung an die Engine im Hinblick auf weitere Optimierungen evaluiert. Anhand von klaren Zielen kann die Arbeit am Training eines NNUE und an der Engine fortgesetzt werden. Die weiterführende Entwicklung der Engine kann unter https://github.com/rabblerousy/heureka verfolgt werden. Teile der implementierten Klassen werden außerdem zur Aufnahme in die verwendeten Bibliotheken aufbereitet werden.

| Studierender | Simon Hetzer | ||

| Semester | Wintersemester 21/22 | ||

| Studiengang | Digitale Medien und Spiele (Fachbereich Informatik) | ||

| Art der Arbeit | Abschlussarbeit Bachelor |

Sie verlassen die offizielle Website der Hochschule Trier